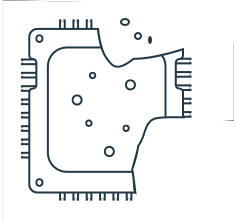

AIME R410 - 4 GPU Rack Server

Ihr Deep Learning-Server auf AMD EPYC Basis, ausgerüstet mit 4 High-End auf KI optimierten GPUs. Mit dem AIME R410 erreichen sie höchste Deep-Learning-Rechenleistung: bis zu 500 Billionen Tensor FLOPS AI-Leistung und 64 GB Hochgeschwindigkeits-GPU-Speicher.

Ausgelegt für den 24/7-Einsatz in Ihrem hauseigenen Rechenzentrum oder Ihrer Co-Location.

AIME R410 - Machine Learning Server

Für Machine-Learning-Anwendungen wird ein neuartiger Typ von Server benötigt. Der AIME R410 Server ist bereit für diese Aufgabe: Mit seiner Multi-GPU-Architektur erreicht er maximale Deep-Learning-Trainings und -Inferenzleistung.

Mit seiner flüssigkeitsgekühlten CPU und einer lüftergestützten GPU-Kühlung, die auf hohen Luftdurchsatz optimiert ist, hält der AIME R410 auch unter Volllast im 24/7-Dauerbetrieb seine höchste Leistung. Sechs aufeinander abgestimmt Hochleistungslüfter erzeugen einen kühlenden Luftstrom durch das System, der die GPUs kühlt und vor Überhitzung schützt. Diese Konfiguration hält das System kühler, leistungsfähiger und ist insgesamt langlebiger, als ein System, das mit einer Ansammlung von vielen kleinen Lüftern arbeitet.

Wählbare Quad GPU Konfigurationen

Wählen sie für die Konfiguration aus den leistungsfähigsten NVIDIA Deep-Learning GPUs:

4 X NVIDIA RTX 2080TI

Jede NVIDIA RTX 2080 TI trainiert AI-Modelle mit 544 NVIDIA Turing mixed-precision Tensor Cores, die eine AI-Leistung von 107 Terra Tensor FLOPS liefern und bietet 11 GB ultra-schnellen GDDR6 Speicher.

Mit dem AIME R410 erhalten Sie die kombinierte Leistung von vier NVIDIA RTX 2080TI und erreichen damit eine AI-Leistung von mehr als 400 Billionen Tensor-Operationen pro Sekunde.

4 X Nvidia Titan RTX

Angetrieben durch die preisgekrönte Turing™-Architektur, liefert die Titan RTX eine Leistung von 130 Tensor TFLOPs, 576 Tensor Cores und 24 GB ultra-schnellen GDDR6 Speicher.

Mit dem AIME R410 erhalten Sie die kombinierte Leistung von vier Titan RTX und erreichen damit eine AI-Leistung von mehr als 500 Billionen Tensor-Operationen pro Sekunde.

4 x Nvidia Quadro RTX 6000

Die Quadro RTX 6000 ist die Pro-Version der Nvidia Titan RTX, mit einer auf für multi GPU-Systeme optimierten Belüftung, zusätzlichen Virtualisierungsfunktionen und ECC-Speicher.

Die Quadro RTX 6000 wird von demselben Turing™ Chip mit 576 Tensorkerne wie die Titan RTX angetrieben und bietet 130 Tensor-TFLOPs Leistung und 24 GB ultraschnellen GDDR6-ECC-Speicher.

Mit dem AIME R500 erhalten Sie die kombinierte Leistung von vier Nvidia Quadro RTX 6000 und erreichen damit eine AI-Leistung von mehr als 500 Billionen Tensor-Operationen pro Sekunde.

4 X Nvidia Tesla V100

Mit 640 Tensor Cores, ist der Tesla V100 der weltweit erste Grafikprozessor, der bei der Deep-Learning-Leistung die 100-TOPS-Schallmauer durchbricht.

Ausgestattet mit 16 GB HBM2 Speicher ist die Tesla V100 für die anspruchvollsten Deep-Learning-Anwendungen ausgelegt.

Alle angeboten NVIDIA GPUs werden von NVIDIAs CUDA-X AI SDK inkl. cuDNN und TensorRT angetrieben und werden damit in alle gängige Deep-Learning-Frameworks unterstützt.

EPYC CPU-Leistung

Die High-End AMD EPYC Server-CPU arbeitet mit bis zu 32 Cores und insgesamt 64 Threads pro CPU. Die 128 verfügbaren PCI 3.0-Lanes der AMD EPYC-CPU ermöglichen es, dass alle GPUs mit der maximalen Anzahl PCI Lanes angebunden sind. Dadurch wird die höchste Datenübertragungsrate zwischen der CPU und den GPUs erreicht.

Der Datendurchsatz kann durch die hohe Anzahl verfügbarer CPU-Kerne erheblich verbessert werden, da hierdurch die GPUs optimal mit Aufgaben versorgt werden können, wenn diese für das Preprocessing und die Bereitstellung von Daten genutzt werden.

Bis zu 4 TB High-Speed-SSD-Speicher

Beim Deep Learning müssen hohe Datenmengen verarbeitet und gespeichert werden. Ein hoher Datendurchsatz und schnelle Zugriffszeiten auf die Daten sind daher für schnelle Turnaround-Zeiten unerlässlich. Der AIME R410 kann mit zwei NVMe-SSDs konfiguriert werden, die über PCI-Lanes direkt mit der CPU und dem Hauptspeicher verbunden sind. Wir bieten die folgenden drei zu konfigurierenden SSD-Klassen an:

- QLC-Typ: Hohe Leseraten, durchschnittliche Schreibgeschwindigkeit - am besten zum Lesen von statischen Datenbibliotheken oder Archiven geeignet

- TLC-Typ: Höchste Lese- und Schreibgeschwindigkeit - am besten geeignet für schnellen Lese- / Schreibzugriff auf Dateien

- MLC-Typ: Höchste Lese- und Schreibgeschwindigkeit - am besten geeignet für Hochleistungsdatenbanken, Datenstreaming und Virtualisierung

Höchste Konnektivität mit Managment Interface

Mit den zwei verfügbaren 10-Gbit/s LAN-Ports sind die schnellsten Verbindungen zu NAS-Ressourcen und Big Data Datenbanken möglich. Auch für den Datenaustausch in einem verteilten Compute Cluster ist die höchste verfügbare LAN-Konnektivität ein Muss.

Der AIME R410 ist mit einer dedizierten IPMI-LAN-Schnittstelle ausgestattet. Mit seinem fortschrittlichen BMC kann er fernüberwacht und gesteuert werden (Wake-up / Reset). Diese Eigenschaften ermöglichen eine erfolgreiche Integration des AIME R410 in ein Server-Rack-Cluster.

Aufeinander abgestimmte Komponenten

All unsere Komponenten wurden aufgrund ihrer Energieeffizienz, Haltbarkeit, Kompatibilität und hohen Leistung ausgewählt. Sie sind perfekt aufeinander abgestimmt, so dass keine Leistungsengpässe entstehen. Wir optimieren unsere Hardware im Hinblick auf Kosten pro Leistung, ohne Kompromisse bei der Langlebigkeit und Zuverlässigkeit einzugehen.

Für Machine-Learning-Anwendungen entwickelt

Der AIME R410 wurde zuerst für unsere eigenen Anforderungen für Machine-Learning-Anwendungen entwickelt und hat sich aus jahrelanger Erfahrung mit Deep-Learning-Frameworks und dem Aufbau von PC-Hardware entwickelt.

Unsere Maschinen werden mit vorinstalliertem Linux-Betriebssystem geliefert und sind mit den neuesten Treibern und Frameworks wie Tensorflow, Keras, PyTorch und Mxnet vorkonfiguriert. Loggen Sie sich direkt nach dem Auspacken ein und starten Sie sofort mit Ihrem bevorzugten Machine-Learning-Framework mit der Entwicklung.

Technische Daten

| Typ | Rack Server 6HE, 45cm Tiefe |

| CPU (konfigurierbar) |

EPYC 7261 (8 cores, 2.5 GHz) EPYC 7232 (8 cores, 3.1 GHz) EPYC 7351 (16 cores, 2.4 GHz) EPYC 7302 (16 cores, 3.0 GHz) EPYC 7402 (24 cores, 2.8 GHz) EPYC 7502 (32 cores, 2.5 GHz) |

| RAM | 64 / 128 / 256 GB ECC Speicher |

| GPU Optionen | 4x NVIDIA RTX 2080TI oder 4x NVIDIA Titan RTX oder 4x NVIDIA Tesla V100 |

| Kühlung | CPU flüssigkeitsgekühlt GPUs mit starkem Luftstrom gekühlt Hochleistungslüfter > 100000h MTBF |

| Speicher | Bis zu 2 X 2TB NVMe SSD Konfigurations-Optionen: QLC: 1500 MB/s read, 1000 MB/s write TLC: 3500 MB/s read, 1750 MB/s, write MLC: 3500 MB/s read, 2700 MB/s write |

| Netzwerk | 2 x 10 GBit LAN 1 x IPMI LAN |

| USB | 2 x USB 3.0 Ports (vorne) 2 x USB 3.0 Ports (hinten) |

| PSU | 2000 Watt Leistung 80 PLUS Platinum certified (94% efficiency) |

| Geräusch-Pegel | < 50dBA |

| Abmessungen (BxHxT) | 440 x 265 x 430 mm |