Übersicht der getesteten GPUs

Obwohl wir nur eine kleine Auswahl aller verfügbaren GPUs getestet haben, sind wir der Meinung, dass wir die GPUs abgedeckt haben, die aufgrund ihrer Rechen- und Speicherkapazitäten und ihrer Kompatibilität mit den aktuellen Deep-Learning-Frameworks, nämlich PyTorch und TensorFlow, derzeit am besten für Deep-Learning-Entwicklung und -Training geeignet sind.

Als Referenz werden auch die schon etwas in die Jahre gekommenen GPUs Geforce RTX 2080 Ti und Tesla V100 einbezogen, um den Anstieg der Rechenleistung in den letzten Jahren zu visualisieren.

Tesla V100

Geeignet für: Server

Erhältlich seit: 2017.05

Architektur: Volta

VRAM Speicher (GB): 16 (HBM2)

Cuda Cores: 5120

Tensor Cores: 640

Energieverbrauch (Watt): 250

Speicherbandbreite (GB/s): 900

Geforce RTX 2080TI

Geeignet für: Workstations

Erhältlich seit: 2018.09

Architektur: Turing

VRAM Speicher (GB): 11 (DDR6)

Cuda Cores: 5342

Tensor Cores: 544

Energieverbrauch (Watt): 260

Speicherbandbreite (GB/s): 616

Geforce RTX 3090

Geeignet für:Workstations/Server

Erhältlich seit: 2020.09

Architektur: Ampere

VRAM Speicher (GB): 24 (GDDR6X)

Cuda Cores: 10496 Tensor Cores: 328

Energieverbrauch (Watt): 350

Speicherbandbreite (GB/s): 936

RTX A5000

Geeignet für: Workstations/Server

Erhältlich seit: 2021.04

Architektur: Ampere

VRAM Speicher (GB): 24 (GDDR6)

Cuda Cores: 8192

Tensor Cores: 256

Energieverbrauch (Watt): 230

Speicherbandbreite (GB/s): 768

RTX A6000

Geeignet für: Workstations/Server

Erhältlich seit: 2020.10

Architektur: Ampere

VRAM Speicher (GB): 48 (GDDR6)

Cuda Cores: 10752

Tensor Cores: 336

Energieverbrauch (Watt): 300

Speicherbandbreite (GB/s): 768

AMD Instinct MI100

Geeignet für: Server

Erhältlich seit: 2020.11

Architektur: CDNA (1)

VRAM Speicher (GB): 32 (HBM2)

Stream Prozessoren: 7680

Energieverbrauch (Watt): 250

Speicherbandbreite (TB/s): 1.2

Geforce RTX 4060 TI

Geeignet für:: Workstations

Erhältlich seit: 2023.07

Architecture: Ada Lovelace

VRAM Speicher (GB): 16 (GDDR6)

Cuda Cores: 4352

Tensor Cores: 136

Energieverbrauch (Watt): 165

Speicherbandbreite (GB/s): 288

Geforce RTX 4090

Geeignet für: Workstations

Erhältlich seit: 2022.10

Architektur: Ada Lovelace

VRAM Speicher (GB): 24 (GDDR6X)

Cuda Cores: 16384

Tensor Cores: 512

Energieverbrauch (Watt): 450

Speicherbandbreite (GB/s): 1008

RTX 4500 Ada

Geeignet für: Server

Erhältlich seit: 2023.08

Architektur: Ada Lovelace

VRAM Speicher (GB): 23 (GDDR6)

Cuda Cores: 7.680

Tensor Cores: 240

Energieverbrauch (Watt): 210

Speicherbandbreite (GB/s): 432

RTX 5000 Ada

Geeignet für: Server

Erhältlich seit: 2023.08

Architektur: Ada Lovelace

VRAM Speicher (GB): 32 (GDDR6)

Cuda Cores: 12800

Tensor Cores: 400

Energieverbrauch (Watt): 250

Speicherbandbreite (GB/s): 576

RTX 6000 Ada

Geeignet für: Workstations/Server

Erhältlich seit: 2022.09

Architektur: Ada Lovelace

VRAM Speicher (GB): 48 (GDDR6)

Cuda Cores: 18176

Tensor Cores: 568

Energieverbrauch (Watt): 300

Speicherbandbreite (GB/s): 960

NVIDIA L40S

Geeignet für: Server

Erhältlich seit: 2022.09

Architektur: Ada Lovelace

VRAM Speicher (GB): 48 (GDDR6)

Cuda Cores: 18176

Tensor Cores: 568

Energieverbrauch (Watt): 300

Speicherbandbreite (GB/s): 864

Geforce RTX 5090

Geeignet für: Workstations

Erhältlich seit 2025.02

Architektur: Blackwell

VRAM Speicher (GB): 32 (GDDR7)

Cuda Cores: 21.760

Tensor Cores: 680

Energieverbrauch (Watt): 575

Speicherbandbreite (GB/s): 1800

RTX PRO 4500 Blackwell

Geeignet für: Workstations / Server

Erhältlich seit: 2025.07

Architektur: Blackwell

VRAM Speicher (GB): 32 (GDDR7)

Cuda Cores: 10.496

Tensor Cores: 328

Energieverbrauch (Watt): 200

Speicherbandbreite (GB/s): 896

RTX PRO 5000 Blackwell

Geeignet für: Workstations / Server

Erhältlich seit: 2025.10

Architektur: Blackwell

VRAM Speicher (GB): 48 (GDDR7)

Cuda Cores: 14.080

Tensor Cores: 440

Energieverbrauch (Watt): 300

Speicherbandbreite (GB/s): 1344

RTX PRO 6000 Blackwell Max-Q

Geeignet für: Workstations / Server

Erhältlich seit: 2025.06

Architektur: Blackwell

VRAM Speicher (GB): 96 (GDDR7)

Cuda Cores: 24.064

Tensor Cores: 752

Energieverbrauch (Watt): 300

Speicherbandbreite (GB/s): 1792

RTX PRO 6000 Blackwell Workstation Edition

Geeignet für: Workstations

Erhältlich seit: 2025.05

Architektur: Blackwell

VRAM Speicher (GB): 96 (GDDR7)

Cuda Cores: 24.064

Tensor Cores: 752

Energieverbrauch (Watt): 600

Speicherbandbreite (GB/s): 1792

RTX PRO 6000 Blackwell Server Edition

Geeignet für: Server

Erhältlich seit: 2025.05

Architektur: Blackwell

VRAM Speicher (GB): 96 (GDDR7)

Cuda Cores: 24.064

Tensor Cores: 752

Energieverbrauch (Watt): 600

Speicherbandbreite (GB/s): 1792

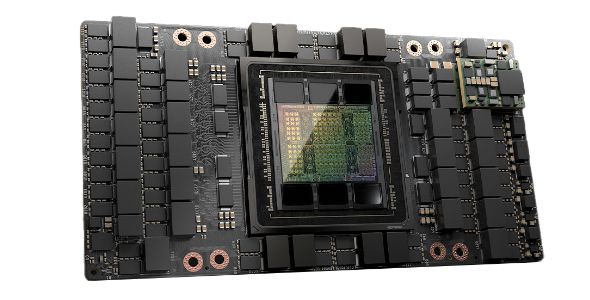

A100

Geeignet für: Server

Erhältlich seit: 2020.05

Architektur: Ampere

VRAM Speicher (GB): 40/80 (HBM2)

Cuda Cores: 6912

Tensor Cores: 512

Energieverbrauch (Watt): 300

Speicherbandbreite (GB/s): 1935 (80 GB PCIe)

H100 80GB

Geeignet für: Server

Erhältlich seit: 2022.10

Architektur: Grace Hopper

VRAM Speicher (GB): 80 (HBM2)

Cuda Cores: 14.592

Tensor Cores: 456

Energieverbrauch (Watt): 350

Speicherbandbreite (GB/s): 2000

H100 NVL

Geeignet für: Server

Erhältlich seit: 2023.07

Architektur: Hopper

VRAM Speicher (GB): 94 (HBM3)

Cuda Cores: 14592

Tensor Cores: 456

Energieverbrauch (Watt): 400

Speicherbandbreite (GB/s): 3900

H200 NVL

Geeignet für: Server

Erhältlich seit: 2024.11

Architektur: Hopper

VRAM Speicher (GB): 141 (HBM3e)

Cuda Cores: 16.896

Tensor Cores: 528

Energieverbrauch (Watt): 600

Speicherbandbreite (GB/s): 4800

H200 SXM

Geeignet für: HGX Server

Erhältlich seit: 2024.11

Architektur: Hopper

VRAM Speicher (GB): 141 (HBM3e)

Cuda Cores: 16.896

Tensor Cores: 528

Energieverbrauch (Watt): 700

Speicherbandbreite (GB/s): 4800

Der Deep Learning Benchmark

Zum Benchmarking der GPUs wird die Trainingsleistung des Sprachmodells BERT Large (in trainierten Sequenzen pro Sekunde) und des visuellen Erkennungsmodells ResNet50 (Version 1.5) (in trainierten Bildern pro Sekunde) herangezogen.

Weitere Informationen zu diesen klassischen Deep-Learning-Netzwerken finden sich hier:

BERT Model

Für unsere Benchmarks verwendeten wir die Variante „BERT large cased“. BERT large ist ein Transformer-Modell mit 24 Schichten, 1024 Hidden Dimensions, 16 Attention Heads und insgesamt 335 Millionen Parametern. Cased bedeutet, dass die verwendete BERT-Version im Input Layer zwischen Groß- und Kleinschreibung unterscheidet.

BERT steht für Bidirectional Encoder Representations from Transformers und ist ein 2018 von Google entwickeltes Deep-Learning-Modell für die Verarbeitung natürlicher Sprache. Es nutzt die Transformer-Architektur, um anhand einer großen Menge unmarkierten ("unlabeled") Textes zu trainieren und eine "in context"-Beziehung natürlicher Sprache aufzubauen. Dazu werden zufällige Wörter im Text verdeckt, und das Modell versucht, die richtigen Wörter zu finden, die in diese Lücken passen. Durch dieses Training kann BERT kontextspezifische Bedeutungen von Wörtern erkennen und mehrdeutige Ausdrücke unterscheiden. Die Besonderheit von BERT ist die bidirektionale Modellierung. Im Gegensatz zu früheren Sprachmodellen, die nur die vorhergehenden Wörter als Kontext betrachteten, modelliert BERT den Kontext bidirektional. Dies bedeutet, dass BERT sowohl die vorhergehenden als auch die folgenden Wörter im Text verwendet, um die Bedeutung eines bestimmten Wortes zu erfassen.

ResNet-50 Model

Das für unsere Benchmarks verwendete ResNet-50-Modell Version 1.5 besteht aus 48 Convolutional-Schichten sowie einer MaxPool- und einer Average-Pool-Schicht, also insgesamt 48+1+1=50 Schichten mit insgesamt 25 Millionen Parametern. Da es in vielen Benchmarks verwendet wird, liefert dies eine nahezu optimale Implementierung zum Vergleichen, die die maximale Leistung aus der GPU herausholt und damit anzeigt, wo die tatsächlichen Rechengrenzen der Hardware liegen.

Ein Residual Neural Network (ResNet) wurde erstmals 2015 zur Bildklassifizierung eingeführt. ResNet gilt als eines der ersten wirklichen Deep-Learning-Netzwerke. Es löste das "Problem der verschwindenden/explodierenden Gradienten" (vanishing/exploding gradients), das in zuvor verwendeten Perceptron-Netzwerkstrukturen auftrat, wenn die Anzahl der Zwischenschichten erhöht wurde (siehe Deep Residual Learning for Image Recognition). Charakteristisch für Residual Networks ist die Verwendung von „Skip-Verbindungen“ zwischen verschiedenen Schichten, die das Überspringen einzelner Schichten ermöglichen. Dies erlaubt die Bildung deutlich tieferer Netzwerke und löst das "Problem verschwindender/explodierender Gradienten".

Für das Benchmarking der Trainingsleistung beider Netzwerke verwenden wir eine PyTorch-Implementierung. PyTorch hat sich zum beliebtesten Deep-Learning-Framework entwickelt und genießt große Unterstützung in der Open-Source-Community. Zudem ist es der De-facto-Standard in der Forschung.

Mit dem in PyTorch 2.0 eingeführten Kompilierungsmodus (compile mode) schloss PyTorch seine Leistungslücke zu anderen Frameworks und erzielt seitdem die beste Trainings- und Inferenzleistung auf GPUs.

Compile Mode

Die Veröffentlichung von PyTorch 2.0 im März 2023 brachte eine Reihe wichtiger Änderungen mit sich, um die Leistung zu verbessern und dynamische Formen (dynamic shapes) sowie verteiltes Training (distributed training) zu unterstützen. Ein wichtiges Leistungsmerkmal von PyTorch 2 ist die Einführung von torch.compile als Haupt-API für PyTorch 2. Diese Funktion umschließt das Modell und gibt ein für die jeweilige GPU kompiliertes und auf den verfügbaren Befehlssatz optimiertes Modell zurück. Dies führt zu einer deutlich besseren Leistung durch die Nutzung der spezifischen Funktionen der GPU-Architektur. Da es vollständig additiv und optional nutzbar ist, bleibt PyTorch 2 sogar abwärtskompatibel. In den meisten Fällen lässt sich die Compilierung des Models durch einfaches Hinzufügen einer Codezeile erreichen:

model = torch.compile(model)

In diesem Benchmark wurde die Trainingsgeschwindigkeit mit den AMP-Tensorauflösungen (Automatic Mixed Precision) fp32 und fp16 verglichen. Diese Auflösungen werden weiterhin für das Training kleiner und mittlerer Modelle (unter 10 Milliarden Parametern) empfohlen.

Numerical Precision: fp32/AMP

Die numerische Präzision, mit der die Gewichte und zugehörigen Werte in Deep-Learning-Modellen berechnet werden, spielt im Trainingsprozess eine wichtige Rolle. Eine höhere Präzision ermöglicht feinere Gewichtsanpassungen, erfordert aber auch mehr Speicher und verlangsamt die Berechnung.

In unseren Benchmarks untersuchen wir die Leistung von „fp32“-Datentypen und Berechnungen, die die „Automatic Mixed Precision“-Technik verwenden.

Der Datentyp „fp32“ (Floating Point 32-Bit) ist der am weitesten verbreitete Standard im Deep Learning. Er verwendet eine 32-Bit-Kodierung mit 1 Bit für das Vorzeichen, 8 Bit für den Exponenten und 23 Bit für die Mantisse.

Automatic Mixed Precision (AMP) ist eine Technik, die in der Deep-Learning-Community immer beliebter wird. Dabei werden während des Trainings unterschiedliche numerische Genauigkeiten (wie fp8, fp16, fp32 und fp64) verwendet, um die Effizienz und Genauigkeit von Deep-Learning-Modellen zu verbessern. Die Idee hinter AMP basiert auf der Tatsache, dass einige Teile des Modells empfindlicher auf numerische Genauigkeit reagieren, als andere. Durch die Verwendung höherer Genauigkeit, wo nötig, und niedrigerer Genauigkeit, wo verzichtbar, können Berechnungen insgesamt schneller und effizienter durchgeführt werden, ohne die Genauigkeit des Modells zu beeinträchtigen. Die Implementierung von "Automatic Mixed Precision" kann jedoch komplex sein und erfordert oft spezielle Hardwareunterstützung.

Der GPU-Vergleich wurde anhand synthetischer, zufällig ausgewählter Bild- und Textdaten durchgeführt, um den Einfluss externer Elemente wie der Art des Datensatzspeichers (SSD oder Netzwerk), des Datenladers und des Datenformats zu minimieren.

Die für den Benchmark verwendeten Python-PyTorch-Skripte sind hier auf Github verfügbar.

Die Testumgebung

Da AIME Server- und Workstation-Lösungen für Deep-Learning-Aufgaben anbietet, verwendeten wir für den Benchmark unseren AIME A4004 Server und unsere AIME G500 Workstation.

Der AIME A4004 Server und die AIME G500 Workstation sind hochentwickelte Umgebungen für den Betrieb mehrerer leistungsstarker GPUs. Sie bieten eine fortschrittliche Stromversorgung und Kühlung, die für maximale Leistung und den Betrieb jeder GPU in einem direkt mit der CPU verbundenen PCIe 5.0 x16-Steckplatz erforderlich ist.

Die technischen Daten zur Reproduktion unserer Benchmarks lauten:

A) Für serverkompatible GPUs:

AIME A4004 Rack Server AMD EPYC 9354 (32 cores), 256 GB DDR5 ECC memory

B) Für GPUs, die für Workstations geeignet sind:

G500 Workstation, AMD Threadripper Pro 7975WX (32 cores), 256 GB DDR5 ECC memory

Verwendung fand außerdem das AIME Machine Learning Container (MLC) Management Framework mit folgendem Setup:

- Ubuntu 22.04 LTS

- NVIDIA-Treiberversion 570.133.7

Für NVIDIA-Karten der Turing-, Ampere-, Ada- und Hopper-Generation:

- CUDA 12.4

- CUDNN 9.1.0

- PyTorch 2.5.1 (offizielle Version)

Für NVIDIA-Karten der Blackwell-Generation:

- CUDA 12.8

- CUDNN 9.7.1

- PyTorch 2.7.0 (offizielle Version)

Die AMD Instinct MI100 GPU wurde getestet mit:

- ROCM 6.2

- MIOpen 2.19.0

- PyTorch 2.5.1 (offizielle Version)

Single GPU Performance

Das Ergebnisse der BERT Large-Leistungsmessungen wird mit der Anzahl der durchschnittlich verarbeiteten Sequenzen pro Sekunde angegeben, die über eine Dauer von 50 Schritte mit der angegeben Batchgröße trainiert werden können. Es wurde der Durchschnitt von drei Durchläufen ermittelt. Die Starttemperatur aller GPUs lag dabei unter 50° Celsius.

Als zweiter Benchmark dienen die Ergebnisse der RESNet50-Leistungsmessungen als Durchschnitt der trainierten Bilder pro Sekunde, die bei einer Ausführung von 50 Schritten mit der angegebenen Batchgröße trainiert werden konnten.

Die beiden verglichenen Anwendungsbeispiele ergeben bezüglich der GPU-Bewertung recht ähnliche Ergebnisse; lediglich in den unteren Rängen findet eine Umordnung statt, da einige GPUs vom RESNet-Modell profitieren, das stärker durch die Speicherbandbreite limitiert ist, als vom BERT-Modell, das stärker durch die Rechenleistung limitiert ist. In der oberen Preisklasse bei GPUs und Beschleunigern ist die Bewertung eindeutig.

Es ist außerdem ersichtlich, dass der Kompiliermodus zwingend erforderlich ist, um die volle Leistung der GPUs und Beschleuniger auszuschöpfen. Insbesondere bei High-End-Beschleunigerkarten führt er zu einer enormen Leistungssteigerung. Die Option „Mixed Precision fp16/AMP“ verdoppelt die Leistung der meisten GPUs und Beschleuniger.

Multi GPU Deep Learning Trainingsleistung

Die nächste Stufe zur Steigerung der Deep Learning-Performance besteht darin, die Arbeits- und Trainingslasten auf mehrere GPUs zu verteilen. Deep Learning skaliert sehr gut auf mehrere GPUs, da diese überwiegend parallel rechnen können und erst nach jedem Backpropagation-Schritt Daten austauschen müssen, um die Gradientenänderungen zu mitteln und auszutauschen.

Der AIME A4004 Server und die AIME G500 Workstation unterstützen bis zu vier serverfähige GPUs.

Wie funktioniert das Multi-GPU Deep-Learning-Training?

Die Methode der Wahl für die Skalierung auf mehrere GPUs ist es, die Batch-Größe über die GPUs zu verteilen. Daher ist die effektive (globale) Batch-Größe die Summe der lokalen Batch-Größen jeder verwendeten GPU. Jede GPU berechnet die Backpropagation für die ihr zugewiesenen Eingaben aus dem Batch-Abschnitt. Die Ergebnisse der Backpropagation jeder GPU werden dann summiert und gemittelt. Die Gewichte des Modells werden entsprechend angepasst und müssen dann wieder an alle GPUs verteilt werden.

Beim Datenaustausch kommt es zu einem Kommunikationsschub, wenn die Ergebnisse eines Batches gesammelt und die Gewichte angepasst werden, bevor der nächste Batch gestartet werden kann. Während die GPUs an der Berechnung eines Batches arbeiten, findet wenig oder gar keine Kommunikation zwischen den GPUs statt.

Bei dieser Standardlösung für die Skalierung auf mehrere GPUs muss sichergestellt werden, dass alle GPUs mit gleicher Geschwindigkeit arbeiten, da sonst die langsamste GPU der Engpass ist, auf den alle anderen GPUs warten müssen. Daher ist das Mischen verschiedener GPU-Typen nicht sinnvoll!

Die nächsten Diagramme zeigen, wie gut die RTX 6000 Ada, RTX 4090 und RTX 5090 in Multi-GPU-Setups skalieren, wenn Berechnungen mit gemischter Genauigkeit von fp32 und fp16 erfolgen.

Es wird ein guter linearer und konstanter Skalierungsfaktor von etwa 0,94 bis 0,95 erreicht. Das bedeutet, dass jede zusätzliche RTX 6000 Ada GPU etwa 95 % ihrer theoretischen linearen Leistung hinzufügt. Der gleiche Skalierungsfaktor wird durch fp16 Mixed-Precision-Training erreicht. Hierbei fällt auf: Eine Konfiguration mit zwei RTX 6000 Ada liefert eine ähnliche Leistung wie ein einzelner H100 80GB-Beschleuniger.

Wie alle NVIDIA Pro GPUs kann die RTX 6000 Ada Peer-to-Peer PCIe Transfer nutzen, um Daten direkt zwischen den GPUs zu übertragen.

Für die RTX 5090 wird die Peer-to-Peer-PCIe-Übertragung von NVIDIA deaktiviert. Die Übertragung über PCIe 5.0 erreicht jedoch immer noch einen guten Skalierungsfaktor zwischen 0,91 und 0,97.

Bei der RTX 4090 stellt sich die Situation anders dar. Während die Single-GPU-Leistung solide ist, bleibt die Multi-GPU-Leistung der RTX 4090 hinter den Erwartungen zurück. Wie die folgende Grafik zeigt, beträgt der Skalierungsfaktor der zweiten RTX 4090 nur 0,62 bis 0,75, was für ein sinnvolles Multi-GPU-Setup ungünstig ist.

Die Begrenzung der Übertragungsgeschwindigkeit ist wahrscheinlich eine beabsichtigte Marktsegmentierung durch NVIDIA, um die Pro-GPUs von der günstigeren NVIDIA GeForce „Consumer“-Serie zu trennen, die nicht in Multi-GPU-Setups verwendet werden soll.

Fazit

Der Kompilierungsmodus ist zwingend erforderlich, um die volle Leistung zu nutzen

Insbesondere bei High-End-Beschleunigerkarten ergibt sich eine enorme Leistungssteigerung um den Faktor 1,5 bis 4!

Mixed Precision kann das Training um mehr als den Faktor 2 beschleunigen

Es zeigt sich, dass es sich für eine Leistungssteigerung lohnen kann, das Training von Float 32-Präzision auf Mixed-Precision-Training umzustellen. Das Anpassen der Software an die jeweiligen Anforderungen könnte ein sehr effizienter Schritt zur Leistungssteigerung sein.

Multi-GPU-Skalierung ist mehr als machbar

Deep-Learning-Leistungsskalierung im Multi-GPU-Betrieb skaliert zumindest für bis zu 8x GPUs sehr gut. Die Verwendung von 2x GPUs übertrifft in den meisten Fällen die nächst leistungsstärkere GPU in Bezug auf Preis und Leistung.

Die parallele Verwendung verschiedener GPU-Typen ist nicht sinnvoll.

Die langsamste GPU gibt den Takt vor, auf die alle anderen GPUs warten müssen!

Welche ist die beste GPU für Deep Learning?

Die Rechenleistung und GPU-Speichergröße sind sicherlich die wichtigsten Aspekte einer GPU für Deep-Learning-Aufgaben, aber auch das Verhältnis von Leistung und benötigtem Stromverbrauch sowie der Formfaktor müssen berücksichtigt werden.

Es kommt also stark auf die Anforderungen des Einsatzszenarios an. Im Folgenden listen wir unsere Einschätzungen für die aktuell vielversprechendsten Deep-Learning-GPUs auf:

RTX PRO 4500 Blackwell

Die NVIDIA RTX PRO 4500 der neuesten Blackwell-GPU-Generation von NVIDIA ist eine starke und effiziente Einstiegskarte. Mit ihren 10.496 CUDA-Kernen, 328 Tensor-Kernen der 5. Generation und 32 GB GDDR7-Speicher sowie einem niedrigen Stromverbrauch von 200 Watt übertrifft sie mit Abstand alle vorherigen NVIDIA-Generationen der RTX A4500/4500 Ada und sogar der RTX A5000/5000 Ada Serie in Leistung, Leistung/Preis und Speicherkapazität.

RTX 5090

Die High-End-NVIDIA-Consumer-GPU der Blackwell-Generation. Ihre Single-GPU-Leistung ist auch aufgrund ihres hohen Strombudgets herausragend.

Die Multi-GPU-Leistung bleibt, wie oben gezeigt, hinter ihrem Potenzial zurück, scheint allerdings nicht mehr so stark limitiert zu sein wie Ihr Vorgänger die RTX 4090.

Diese Limitierung stellt jedoch auch kein Hindernis für Inferenzanwendungen dar, wenn keine Kommunikation zwischen den GPUs erforderlich ist und jede GPU einzeln das entsprechende Modell in den Speicher laden und verarbeiten kann.

RTX PRO 5000 Blackwell

Aktuell ist die RTX PRO 5000 die skalierbare Allround-GPU der Blackwell-Generation mit einem guten Preis-Leistungs-Verhältnis und einer angemessenen Speichergröße, die als Baustein für große Sprachmodell-Inference-Setups genutzt werden kann. Zwei RTX PRO 5000 Blackwell leisten mehr als eine RTX PRO 6000 Server bei vergleichbaren Kosten und Stromanforderungen.

Die RTX PRO 5000 Blackwell übertrifft alle 48 GB NVIDIA-GPUs der vorherigen Generationen wie z.B. die RTX A6000, RTX 6000 Ada / L40S und ist ein mehr als adäquater Ersatz für solche Karten.

RTX PRO 6000 Blackwell

Die Flagschiff-Pro-Allround-GPU der neuesten Blackwell-Serie von NVIDIA ist die RTX PRO 6000 Blackwell mit ungeschlagenen 24.064 CUDA- und 752 Tensor-Kernen der 5. Generation.

Mit der Speichererhöhung auf 96 GB GDDR7-GPU-Speicher und einer beeindruckenden Speicherbandbreite von 1,6 TB/s setzt sie einen neuen Standard in der GPU-Berechnung und effizienten LLM-Inferenz. Die NVIDIA RTX PRO 6000 Blackwell ist in drei Varianten erhältlich:

RTX PRO 6000 Blackwell Workstation Edition

Die aktiv gekühlte Version, geeignet für Office-Workstations, kommt mit einem geräuscharmen Lüfterdesign. Es ist derzeit die leistungsstärkste Office-Workstation-GPU, die verfügbar ist. Aufgrund ihres Formfaktors ist sie jedoch praktisch auf zwei GPUs in einer Workstation beschränkt.

RTX PRO 6000 Blackwell Workstation Max-Q

Die Max-Q-Version hat die gleichen technischen Spezifikationen wie die Workstation Edition, jedoch mit zwei wichtigen Unterschieden: Sie ist auf einen effizienten Stromverbrauch von 300 Watt begrenzt und kommt im aktiven Blower GPU 2-Slot-Format. Dies ermöglicht Server und Workstration mit vier GPU-Systemen einen moderaten Stromverbrauch und mit einer geringen Leistungsreduzierung von ca. 15 % bis 30 % gegenüber der 600-Watt-Version.

RTX PRO 6000 Blackwell Server Edition

Die passiv gekühlte Server-Version ermöglicht es, bis zu acht RTX PRO 6000 Blackwell GPUs in einem Server zu verbauen, was zu einem Gesamtspeicher von 768 GB GPU-Speicher für die Inferenz großer Modelle ermöglicht. Die RTX PRO 6000 Blackwell Server Edition erfordert Server mit den leistungsstärksten Kühl- und Netzteilkapazitäten, wie z.B. dem AIME A8005.

NVIDIA H100 NVL

Der Nachfolger der H100 80 GB, dem aktuellen Standard bei AI Beschleunigern, bietet ca. 30 % mehr Leistung und 14 GB zusätzlichen Speicher. Erreicht wird dies durch schnelleren und dichteren HBM3e-Speicher und eine höhere Leistungsaufnahme von 450 Watt.

Die 450 Watt Leistung stellen immer noch einen Kompromiss zu den 600/700 Watt pro GPU einer H200 NVL- oder eines DGX/HGX-Servers dar. Eine mögliche bessere Rack-Auslastung sowie geringere Energie- und Kühlkosten können bei 24/7-Systemen zu berücksichtigende Faktoren werden.

Ein Octa-(8x)-NVIDIA-H100-NVL-Setup, wie es mit dem AIME A8004 möglich ist, katapultiert den Anwender in den Multi-PetaFLOPS-HPC-Bereich.

NVIDIA H200 NVL / SXM

Wenn höchste Leistung unabhängig vom Preis und die höchste Leistungsdichte gefragt sind, ist die NVIDIA H200 aktuell die erste Wahl: Sie bietet erstklassige Deep-Learning- und Inferenzleistung.

Der 141 GB große HBM3e-Speicher ist der entscheidende Vorteil der H200 für die Skalierung mit größeren Modellen.

Die H200 NVL als PCIe 5.0-Kartenlösung ist in Konfigurationen mit 1 bis 8 GPUs im AIME A8005-Server verfügbar. Die Leistung entspricht nahezu der der H200 SXM-Version, obwohl sie 100 Watt weniger Strom benötigt. Die H200 NVL kann mit NVLink-Brücken ausgestattet werden, um eine 4-Wege-NVLink-Übertragung von 900 GB/s zwischen vier Beschleunigern dieses Typs zu ermöglichen.

Die H200 SXM ist für den Einsatz in HGX-Servern wie dem AIME GX8-H200 vorgesehen und ausschließlich als 8x-GPU-Lösung mit vollständiger NVLink-Verbindung zwischen allen H200 SXM-GPUs verfügbar.

Der AIME GX8-H200 Server ist die Clusterlösung zur Skalierung von GPU-Computing über mehrere Server hinweg. Jede GPU kann über einen schnellen 400-GB-LAN-Switch verbunden werden, um Daten direkt mit allen anderen GPUs im Cluster auszutauschen.

Dieser Artikel wird aktualisiert, sobald neue Ergänzungen und Korrekturen verfügbar sind.

Fragen oder Anmerkungen? Kontaktieren Sie uns gerne unter: hello@aime.info