High End Multi-GPU-Server mieten

Optimiert für Maschinelles Lernen, Deep Learning und Big Data Analysen

Die Multi-GPU-Instanzen der AIME-Cloud-Server enthalten leistungsstarke NVIDIA-GPUs wie die RTX A5000, RTX 6000 Ada oder mehrere NVIDIA A100 oder H100 Beschleuniger. Sie erfüllen die hohen Anforderungen massiver paralleler HPC Anwendungen wie z.B. Deep Learning und Rendering.

Mit allen Vorteilen von On-Demand-Ressourcen können sie wöchentlich oder monatlich genutzt werden. Die ideale Lösung für Berechnungen wie Training eines Deep-Learning Models auf Projektbasis aber auch als Ihr dedizierter Bare-Metal-Server, mit jährlicher Laufzeit, überzeugt die AIME GPU Cloud als wartungsfreie Lösung mit einem günstigen TCO.

Kundenvertrauen in ganz Europa

In ganz Europa verwenden Forscher und Ingenieure an Universitäten, in Start-Ups, großen Unternehmen, Behörden und nationalen Labors etc. AIME-Produkte für ihre Arbeit zur Entwicklung künstlicher Intelligenz.

Preise

Storage Erweiterung

Zusätzlicher NAS-Speicher für Ihre Server oder Instanzen.

Netzwerk Erweiterung

Verbinden Sie Ihre Server mit einem Hochgeschwindigkeits-VLAN mit 10 oder 100 Gbit/s für verteilte Berechnungen.

Maßgeschneiderte Lösungen

Vermissen Sie Ihre Konfiguration? Wir können fast alle AIME-Server-Hardwarekonfigurationen auch als gehostete Lösung anbieten.

Server einrichten

Schritt 1: Reservieren

Wählen Sie Ihre gewünschte Konfiguration und wir richten Ihr Konto ein.

Schritt 2: Anmelden und Konfigurieren

Melden Sie sich über ssh oder Remotedesktop bei Ihrer dedizierten Instanz an.

Alles ist bereits installiert und dank des AIME ML-Containersystems kann Ihr bevorzugtes Deep Learning-Framework sofort mit einem einzigen Befehl konfiguriert werden:

> mlc create my-container Pytorch 2.5.0

Schritt 3: Beginnen Sie zu arbeiten!

Ihr Deep-Learning-Framework ist einsatzbereit.

> mlc open my-container

Dedizierte Multi-GPU-Server-Vermietung, optimiert für die AI-Entwicklung

Höchste Leistung

Zugriff auf Bare-Metal-Hardware-Leistung: Volle CPU-, Multi-GPU- und SSD-Bandbreite ohne Leistungseinbußen aufgrund von Virtualisierung und ohne gemeinsame Nutzung der Hardware mit Nachbarn, die sich unsozial verhalten und Ihre Maschine bei ihren Aufgaben blockieren könnten.

Jeder Server ist mit einer LAN-Bandbreite von 10 GBit/s verbunden und verfügt über mindestens 100 MBit/s Upstream- und 500 Mbit/s Downstream-Internetkapazität.

Einfach losarbeiten

- keine Verzögerung

- Keine Setup-Komplikationen

- Keine Wartung

Minimale anfängliche Wartezeit, um Zugriff auf die erforderlichen Multi-GPU-Ressourcen zu erhalten. Keine Liefer- und Einrichtungszeit, beginnen Sie sofort mit Ihren Experimenten.

Konzentrieren Sie sich auf Ihre Forschung, Modell-Trainings und die Entwicklung Ihrer Anwendung und wir kümmern uns um die Wartung und den Betrieb der Hardware in einer idealen Serverumgebung.

Skalieren nach Bedarf

Benötigen Sie mehr CPU-Kerne, mehr RAM, schnelleren Speicher oder möchten Sie auf leistungsstärkere GPUs aktualisieren?

Hardware-Upgrades sind auf Anfrage erhältlich. Sagen Sie uns einfach, was Sie brauchen, und wir aktualisieren Ihr System nach Ihren Anforderungen. Für mehrere Instanzen bieten wir deren Verbindung mit einem dedizierten 10 GBit/s oder 100 GBit/s VLAN. Auch eine nahtlose Migration auf einen neuen Server ist für uns kein Problem.

Immer zugänglich, und dabei sicher

Ihr Server läuft sicher hinter unserer Firewall, verfügt jedoch über eine vollständige Hochgeschwindigkeits-Verbindung zum Internet. Er ist über ein sicheres Shell-Gateway zugänglich und für die Verwendung als Remote-Ubuntu-Desktop-Maschine für mehrere Benutzer gleichzeitig mit einer vollständig durch das SSH-Protokoll verschlüsselten und gesicherten Verbindung konfiguriert.

Nutzen Sie alle Vorteile von Thin Clients, arbeiten Sie lediglich auf Ihrem Notebook und überlassen Sie die 24/7-Hochgeschwindigkeits-Berechnungen Ihrem AIME Remote-Server.

Alles inklusive

Alle Kosten für den Betrieb eines Hochleistungsservers sind enthalten: Raummiete, Internetbandbreite und insbesondere Strom- und Kühlkosten. Außerdem fallen keine zusätzlichen Wartungs- und Servicekosten an.

Für kurz- und mittelfristig laufende Projekte (<1 Jahr) weist ein AIME-dedizierter Multi-GPU-Server unschlagbar niedrige TCO-Werte ('True Cost of Ownership') auf.

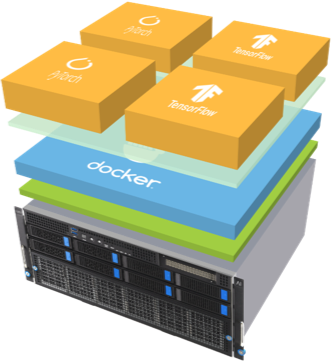

Optimiert für Deep-Learning

Unsere Instanzen werden unter Linux vorinstalliert und mit den neuesten Multi-GPU-Treibern und -Bibliotheken konfiguriert.

Mit dem vorinstallierten AIME ML Container Manager können Sie problemlos AI-Projekte einrichten und zwischen Frameworks und Projekten navigieren. Die gebräuchlichsten Frameworks - u.a. TensorFlow, Keras, PyTorch und Mxnet, können mittels eines einzigen Befehls sofort verwendet werden.

Weiterlesen: AIME Machine Learning Framework Container Management

Testen vor dem Kauf

Möchten Sie sicherstellen, dass Ihre geplante Hardware Ihren Anforderungen entspricht? Testen Sie unsere Server aus der Ferne direkt für Ihre individuellen Anwendungsfälle. Wenn Sie mit der Leistung zufrieden sind, verpacken wir Ihr Gerät und liefern es Ihnen. Sie können es dann in Ihre eigene Serverumgebung integrieren und direkt weiter arbeiten lassen.

Kontaktieren Sie uns

Wenn sie Fragen haben rufen Sie uns an oder senden Sie uns eine E-Mail. Wir helfen Ihnen gerne bei der Suche nach der am besten geeigneten Rechenlösung.

-

AIME GmbH

Marienburger Str. 1

10405 Berlin

Deutschland