AIME A8004 - Multi GPU HPC Rack Server

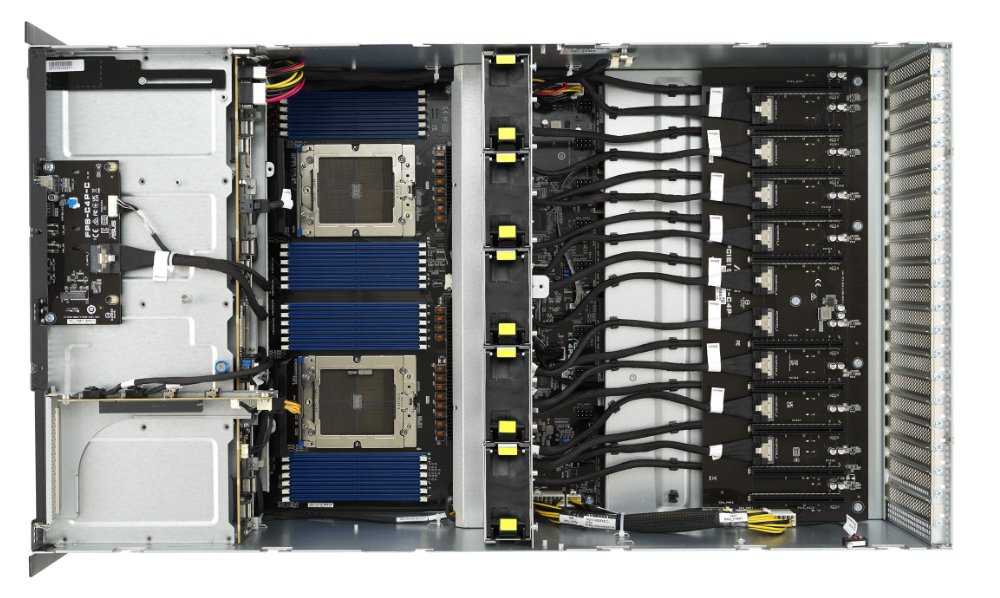

Der AIME A8004 Enterprise Deep Learning-Server basiert auf dem ASUS ESC8000A-E12 Barebone. Im 4HE-Formfaktor ist er mit bis zu acht der fortschrittlichsten Deep Learning-Beschleuniger bzw. GPUs konfigurierbar.

Treten Sie ein ins Peta-FLOPS-HPC Zeitalter mit mehr als 8 Peta-TensorOps Deep Learning-Leistung: Dual EPYC Genoa CPUs mit bis zu 2 TB Hauptspeicher, PCIe 5.0 Bus -Geschwindigkeit sowie bis zu 100 GBE Netzwerkkonnektivität.

Entwickelt für den 24/7-Betrieb für zuverlässigstes High Performance Computing, entweder in Ihrem eigenen Rechenzentrum, Co-Location oder als gehostete Lösung.

AIME A8004 - Deep Learning Server

Der AIME A8004 Multi-GPU 4U Rack Server ist auf maximale Deep-Learning-Trainings- und Inferenzleistung, sowie auf höchste Anforderungen im HPC-Computing spezialisiert.

Er basiert auf dem neuen ASUS ESC8000A-E12 Barebone, der von zwei AMD EPYC™ Genoa Prozessoren mit jeweils bis zu 96 Kernen angetrieben wird. Insgesamt ergibt sich eine CPU-Leistung von bis zu 384 parallel berechenbaren CPU-Threads.

Sein GPU-optimiertes Design mit hoher Luftstromkühlung ermöglicht den Einsatz von acht High-End-Doppelslot-GPUs, wie den neuesten NVIDIA H100, NVIDIA A100, NVIDIA L40S, RTX 6000 Ada, RTX 5000 Ada GPU-Modellen.

Definierbare GPU-Konfiguration

Wählen Sie für Ihre Wunsch- Konfiguration aus den leistungsstärksten NVIDIA-GPUs für Deep Learning und Rendering:

Bis zu 8x NVIDIA H100

Die NVIDIA H100 ist das Flaggschiff der NVIDIA Hopper Prozessorgeneration und der Nachfolger der bekannten NVIDIA A100 Beschleunigerkarten. Sie basiert auf dem GH-100 Prozessor in TSMC 4N Fertigung mit 14592 CUDA Kernen, 456 Tensor-Kernen der vierten Generation und 80 GB HBM2 Speicher. Ein einzelner NVIDIA H100 Grafikprozessor durchbricht bereits die Peta-fp16-Leistungsgrenze. Acht Beschleuniger dieses Typs summieren sich zu mehr als 6.000 teraFLOPS tf32 und bis zu 72.000 teraTOPS fp8 Leistung. Die NVIDIA H100 ist die derzeit effizienteste und schnellste Deep-Learning-Beschleunigerkarte auf dem Markt. Die H100 ist auch die erste Beschleunigerkarte, die von den Übertragungsraten von bis zu 64 GB/s über den PCIe 5.0 Bus des AIME A8004 profitiert.

Bis zu 8x NVIDIA A100

Die NVIDIA A100 ist das Flaggschiff der NVIDIA Ampere Prozessorgeneration und der Nachfolger der legendären NVIDIA Tesla V100 Beschleunigerkarten. Sie basiert auf dem GA-100 Prozessor in 7nm Fertigung mit 6912 CUDA Kernen, 432 Tensor-Kernen der dritten Generation und 40 oder 80 GB HBM2 Speicher mit höchsten Datentransferraten. Ein einzelner NVIDIA A100 Grafikprozessor durchbricht bereits die Peta-TOPS-Leistungsgrenze. Acht Beschleuniger dieses Typs summieren sich auf mehr als 2.000 teraFLOPS fp32-Leistung.

Bis zu 8x NVIDIA RTX 6000 Ada

Die RTX ™ 6000 Ada basiert auf der neuesten NVIDIA GPU-Architektur: Ada Lovelace. Sie ist die direkte Nachfolgerin der RTX A6000 und der Quadro RTX 8000. Die RTX 6000 Ada kombiniert 568 Tensor Cores der vierten Generation und 18.176 CUDA® Cores der nächsten Generation mit 48 GB Grafikspeicher für beispiellose Leistung für Rendering, Grafik und KI.

Bis zu 8x NVIDIA L40S 48GB

Die NVIDIA L40S basiert auf der neuesten NVIDIA-GPU-Architektur: Ada Lovelace. Sie ist der direkte Nachfolger der RTX A40 und die passiv gekühlte Version der RTX 6000 Ada. Die L40S kombiniert 568 Tensor-Kerne der vierten Generation und 18.176 next-gen CUDA®-Kerne mit 48 GB GDDR6 Grafikspeicher für beispiellose Leistung für Rendering, Grafik und KI.

Bis zu 8x NVIDIA RTX 5000 Ada

Die RTX ™ 5000 Ada basiert auf der neuesten NVIDIA GPU-Architektur: Ada Lovelace. Sie ist die direkte Nachfolgerin der RTX A5000/A5500 und der Quadro RTX 6000. Die RTX 5000 Ada kombiniert 400 Tensor Cores der vierten Generation und 12.800 CUDA® Kerne der nächsten Generation mit 32 GB Grafikspeicher für eine überzeugende Rendering-, KI-, Grafik- und Rechenleistung.

Bis zu 8x NVIDIA RTX A5000

Die NVIDIA RTX A5000 hat mit ihren 8.192 CUDA- und 256 Tensor-Kernen der Ampere-Generation etwa die Leistung einer RTX 3090. Mit 230 Watt Leistungsaufnahme und 24 GB Speicher ist sie jedoch eine sehr effiziente Beschleunigerkarte und gerade für Inferenzaufgaben eine sehr interessante Option.

Alle NVIDIA-GPUs werden von NVIDIAs CUDA-X AI SDK unterstützt, einschließlich cuDNN und TensorRT, die fast alle gängigen Deep-Learning-Frameworks unterstützen.

Dual EPYC CPU Leistung

Die neueste AMD EPYC Server-CPU mit Unterstützung für DDR5 und PCIe 5.0 liefert bis zu 96 Kerne mit insgesamt 192 Threads pro CPU zu einem unschlagbaren Preis-Leistungs-Verhältnis.

Die verfügbaren 2x 128 PCI 5.0 CPU-Lanes der AMD EPYC CPU ermöglichen höchste Interconnect- und Datentransferraten zwischen der CPU und den GPUs und stellen sicher, dass alle GPUs mit voller x16 PCI 5.0-Bandbreite angeschlossen sind.

Eine große Anzahl verfügbarer CPU-Kerne kann die Leistung drastisch verbessern, wenn die CPU für die Vorverarbeitung und Bereitstellung von Daten verwendet wird, um die GPUs optimal mit Arbeitslasten zu versorgen.

Bis zu 30 TB direkter NVMe SSD-Speicher

Deep Learning ist in den meisten Fällen mit einer großen Menge an zu verarbeitenden und zu speichernden Daten verbunden. Ein hoher Durchsatz und schnelle Zugriffszeiten auf die Daten sind entscheidend für schnelle Durchlaufzeiten.

Der AIME A8004 kann mit bis zu zwei austauschbaren U.2 NVMe Triple Level Cell (TLC) SSDs mit einer Kapazität von jeweils bis zu 15,36 TB konfiguriert werden, was sich zu einer Gesamtkapazität von 30 TB schnellstem NVMe SSD-Speicher addiert.

Da jede der SSDs über PCI 4.0-Lanes direkt mit der CPU und dem Hauptspeicher verbunden ist, erreichen sie konstant hohe Lese- und Schreibgeschwindigkeiten von mehr als 4.000 MB/s.

Optionales RAID: Bis zu 60 TB NVMe SSD-Speicher

Für die weitere Speicherung großer Datensätze und Trainingskontrollpunkte wird oft zusätzliche Speicherkapazität benötigt. Der A8004 bietet die Möglichkeit, seine sechs zusätzlichen Laufwerksschächte mit einer zuverlässigen Hardware-RAID-Konfiguration zu nutzen. Bis zu 60 TB schnellster NVME-SSD-Speicher mit den RAID-Levels 0 / 1 / 5 / 10 und 50.

Wie im Serverbereich üblich, haben die SSDs eine MTBF von 2.000.000 Stunden bei 1 DWPD und eine 5-jährige Herstellergarantie.

Hohe Konnektivität und Management-Schnittstelle

Der A8004 kann mit 2x 10 Gbit/s RJ45/SFP+ LAN-Ports oder mit bis zu 2x 100 Gbit/s (GBE) Netzwerkadaptern ausgestattet werden, um eine optimale Anbindung an NAS-Ressourcen und große Datensammlungen zu ermöglichen. Auch für den Datenaustausch in einem verteilten Computing-Cluster ist die höchstmögliche LAN-Konnektivität ein Muss.

Der AIME A8004 ist über ASMB11-iKVM IPMI/BMC, unterstützt durch AST2600, vollständig fernverwaltbar, was eine erfolgreiche Integration des AIME A8004 in größere Server-Cluster ermöglicht.

Optimiert für Multi-GPU-Server-Anwendungen

Der AIME A8004 bietet Energieeffizienz durch redundante Titanium-Netzteile, die einen ausfallsicheren Langzeitbetrieb ermöglichen.

Seine thermische Kontrolltechnologie sorgt für einen effizienteren Stromverbrauch in groß-skaligen Umgebungen.

AIME liefert den A8004 einsatzbereit vorkonfiguriert, optimiert auf Multi-GPU-Dauerleistung, wie sie für Deep-Learning Anwendungen benötigt wird.

Der A8004 wird mit einem vorinstallierten Ubuntu Linux-Betriebssystem geliefert, das mit den neuesten Treibern und Frameworks wie Tensorflow, Keras und PyTorch konfiguriert ist. Beginnen Sie sofort nach dem ersten Booten mit dem Training oder Inferenz Ihrer Deep-Learning-Anwendung.

Technische Details

| Typ | Rack-Server 4HE, 80cm depth |

| CPU (konfigurierbar) |

EPYC Bergamo 2x EPYC 9754 (128 cores, 2.25 / 3.1 GHz) 2x EPYC 9734 (112 cores, 2.2 / 3.0 GHz) EPYC Genoa 2x EPYC 9124 (16 cores, 3.0 / 3.7 GHz) 2x EPYC 9224 (24 cores, 2.5 / 3.7 GHz) 2x EPYC 9354 (32 cores, 3.25 / 3.8 GHz) 2x EPYC 9454 (48 cores, 2.75 / 3.8 GHz) 2x EPYC 9554 (64 cores, 3.1 / 3.75 GHz) 2x EPYC 9654 (96 cores, 2.4 / 3.7 GHz) |

| RAM | 256 / 512 / 1024 / 1536 / 2048 / 3072 GB DDR5 ECC memory |

| GPU Optionen |

1 bis 8x NVIDIA H100 NVL 94GB oder 1 bis 8x NVIDIA H100 80GB oder 1 bis 8x NVIDIA A100 80GB oder 1 bis 8x NVIDIA RTX L40S 48GB oder 1 bis 8x NVIDIA RTX 6000 Ada 48GB oder 1 bis 8x NVIDIA RTX 5000 Ada 32GB oder 1 bis 8x NVIDIA RTX A5000 24GB |

| Kühlung | Die GPUs werden mit einem Luftstrom gekühlt, der von 5 temperaturgesteuerten Hochleistungslüftern erzeugt wird (> 100000h MTBF) System-Lüfter: CPUs und Mainboard werden mit einem Luftstrom gekühlt, der von 6 unabhängigen, temperaturgesteuerten Hochleistungslüftern bereitgestellt wird (> 100000h MTBF) |

| Storage |

Bis zu 4 TB built-in M.2 NVMe PCIe 4.0 SSD (optional) Bis zu 2x 15.36 TB U.2 NVMe PCIe 4.0 SSD Tripple Level Cell (TLC) quality 6800 MB/s read, 4000 MB/s write MTBF von 2.000.000 Stunden und 5 Jahre Herstellergarantie mit 1 DWPD Optionales Hardware RAID: Bis zu 6x SSD 7.68 TB SATA RAID 0/1/5/10 oder Bis zu 6x SSD 3.84 TB NVMe RAID 0/1/5/10 oder Bis zu 6x SSD 7.68 TB NVMe RAID 0/1/5/10 oder Bis zu 6x SSD 15.36 TB NVMe RAID 0/1/5/10 |

| Netzwerk |

1 x IPMI LAN 2 x 10 GBE LAN RJ45 oder 2 x 10 GBE LAN SFP+ oder 2 x 25 GBE LAN SFP28 oder 1 x 100 GBE QSFP28 |

| USB | 2 x USB 3.2 ports (Front) |

| Netzteile | 2+2x 3000W redundante Leistung 80 PLUS Titanium zertifiziert (96% Effizienz) |

| Geräusch-Pegel | 88dBA |

| Abmessungen (BxHxT) | 440mm x 176mm (4HE) x 800mm

17.6" x 6.92" x 31.5" |

Betriebsumgebung | Betriebs-Temperatur: 10℃ ~ 35℃

Nicht-Betriebs-Temperatur: -40℃ ~ 70℃ |