AIME MLC

Das Deep Learning Framework Management System

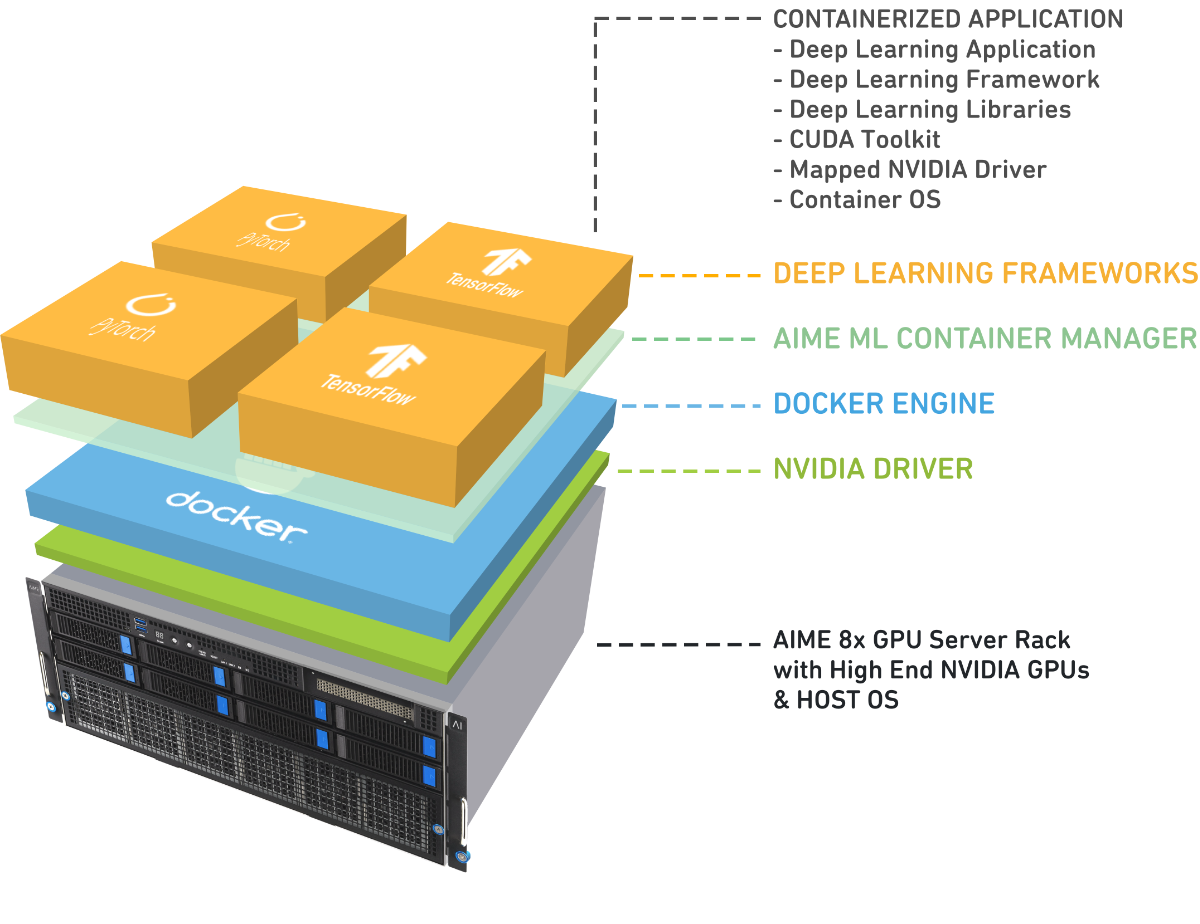

Der AIME Machine Learning Container Manager (AIME MLC) ist ein Framework, das die Bereitstellung und Verwaltung von Deep-Learning-Umgebungen auf Basis von Docker deutlich vereinfacht. Notwendige Bibliotheken, GPU-Treiber und Betriebssystem-Bibliotheken für verschiedene Versionen von Deep-Learning-Frameworks werden in vorgefertigten Docker-Containern gebündelt und können mit nur einem einzigen Befehl gestartet werden. Dies bietet Forschern und Entwicklern maximale Flexibilität, insbesondere beim Experimentieren mit unterschiedlichen KI-Modellen.

AIME MLC erleichtert die Arbeit mit Deep-Learning-Frameworks wie TensorFlow und PyTorch und ist vielseitig für verschiedene Anwendungsbereiche der künstlichen Intelligenz einsetzbar. Anwender können Umgebungen individuell anpassen, z. B. durch die Auswahl bestimmter CUDA-Versionen, Treiber, Betriebssystem- und Python-Bibliotheken. So lassen sich Konfigurationen gezielt für spezifische Projekte oder Hardware-Setups definieren und schnell zwischen verschiedenen Projekten oder Benutzern wechseln.

AIME ML Container Manager

für Training und Inferenz von KI-Modellen

Der Container Manager ist besonders nützlich für die KI-Forschung und -Entwicklung, Unternehmenslösungen im KI-Bereich sowie für alle Anwendungen, die eine intensive Nutzung von GPUs erfordern, wie z. B. das Training von KI-Modellen.

Ein zentraler Vorteil von AIME MLC ist die nahtlose Integration in Hochleistungs-GPU-Umgebungen, wie sie von der AIME Cloud-Infrastruktur bereitgestellt werden. Dies macht es besonders effektiv für Anwendungen mit hohen Rechenanforderungen, z. B. das Training von Deep-Learning-Modellen auf Multi-GPU-Systemen. Das Framework ermöglicht eine effiziente Ressourcenverteilung und -verwaltung, wodurch Leistung und Skalierbarkeit optimiert werden.

AIME-Server und -Workstations werden standardmäßig mit dem vorinstallierten AIME ML Container Manager ausgeliefert. Durch die Integration mit den Hochleistungs-GPU-Cloud-Diensten von AIME bietet er eine robuste Infrastruktur, um Deep-Learning-Projekte und Frameworks schnell einzurichten, zu beschleunigen und nahtlos zwischen ihnen zu wechseln.

Der AIME ML Container Manager erleichtert Entwicklern den Arbeitsalltag, da sie sich nicht mehr mit den typischen Problemen bei der Installation von Framework-Versionen auseinandersetzen müssen.

1

Schritt 1: Konfiguration

Melden Sie sich über ssh oder Remotedesktop bei Ihrer dedizierten Instanz an. Alles ist bereits installiert und dank des AIME ML-Containersystems kann Ihr bevorzugtes Deep Learning-Framework sofort mit einem einzigen Befehl konfiguriert werden:

> mlc create my-container Pytorch 2.5.0

2

Schritt 2: Beginnen Sie zu arbeiten!

Ihr Deep-Learning-Framework ist einsatzbereit. Sie können jetzt mit der Entwicklung, dem Training oder der Bereitstellung Ihres Modells beginnen, z. B. als AIME-API-Worker, um Ihre Anwendung zu skalieren!

> mlc open my-container

AIME Benchmarking Suite

Leistungsanalyse mit umfassenden Benchmarking-Tools

Als Hard- und Softwareunternehmen hat AIME eine Suite von Benchmarking-Tools entwickelt, um die KI-Leistung in verschiedenen Hard- und Softwarekonfigurationen zu bewerten und zu optimieren.

Die AIME Benchmarking Suite liefert detaillierte Einblicke durch:

- GPU-Benchmarking: Von der RTX 3090 bis zu den neuesten H200-Modellen.

- Bewertung von KI-Modellleistung: Analyse von Inferenz und Training auf unterschiedlichen Konfigurationen und GPUs mithilfe gängiger Open-Source-KI-Modelle.

- Framework-Tests: Benchmarking von PyTorch und TensorFlow auf Multi-GPU-Setups, voll kompatibel mit NVIDIA CUDA und AMD ROCm.

Zusätzlich bieten wir ein spezielles Benchmarking-Tool für den AIME API Server an. Dieses Tool ermöglicht es, die Leistung der angeschlossenen KI-Modelle (GPU-Worker) zu testen, zu überwachen und zu vergleichen. So können KI-Deployments gezielt optimiert werden, um maximale Effizienz und Zuverlässigkeit sicherzustellen.

Die gewonnenen Erkenntnisse fließen direkt in unsere Beratungs- und Optimierungsleistungen ein, sodass unsere Kunden fundierte Entscheidungen über ihre Hard- und Software-Konfigurationen treffen und eine optimale Leistung für ihre KI-Workloads erzielen können.

Erfahren Sie mehr über unsere Benchmark-Ergebnisse in unseren praxisnahen Blog-Artikeln, die wir regelmäßig zu aktuellen Open-Source-KI-Modellen veröffentlichen, zum Beispiel zu:

- Pytorch Benchmarks

- GPU Benchmarks

- Llama 3.x Blog Articles

- FLUX-Benchmarks

Integriert in OpenWebUI, vLLM-ready

Datensouveränität und Datenschutz mit OpenWebUI- und vLLM-Integration

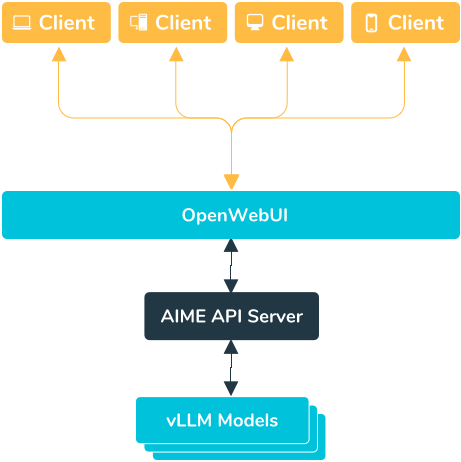

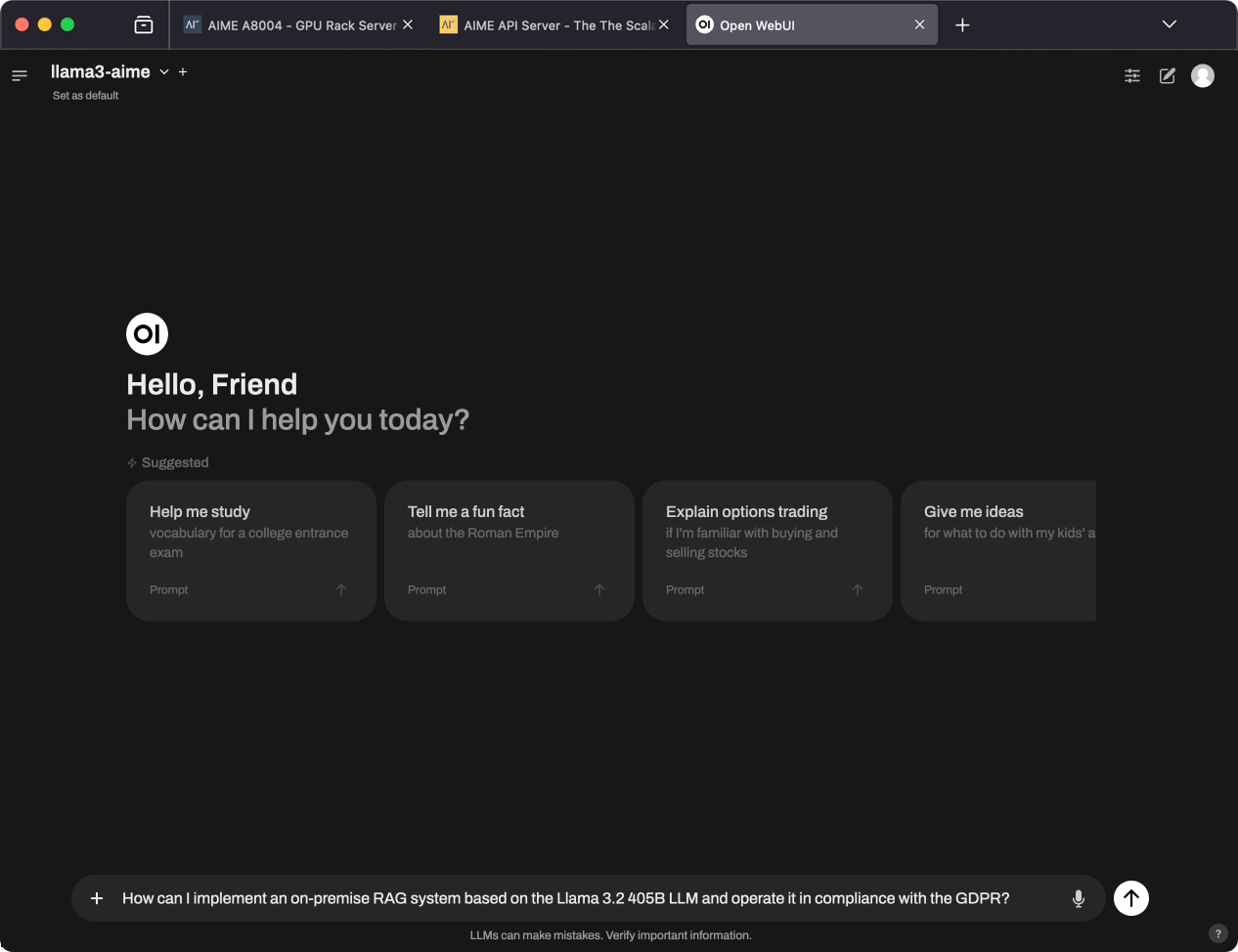

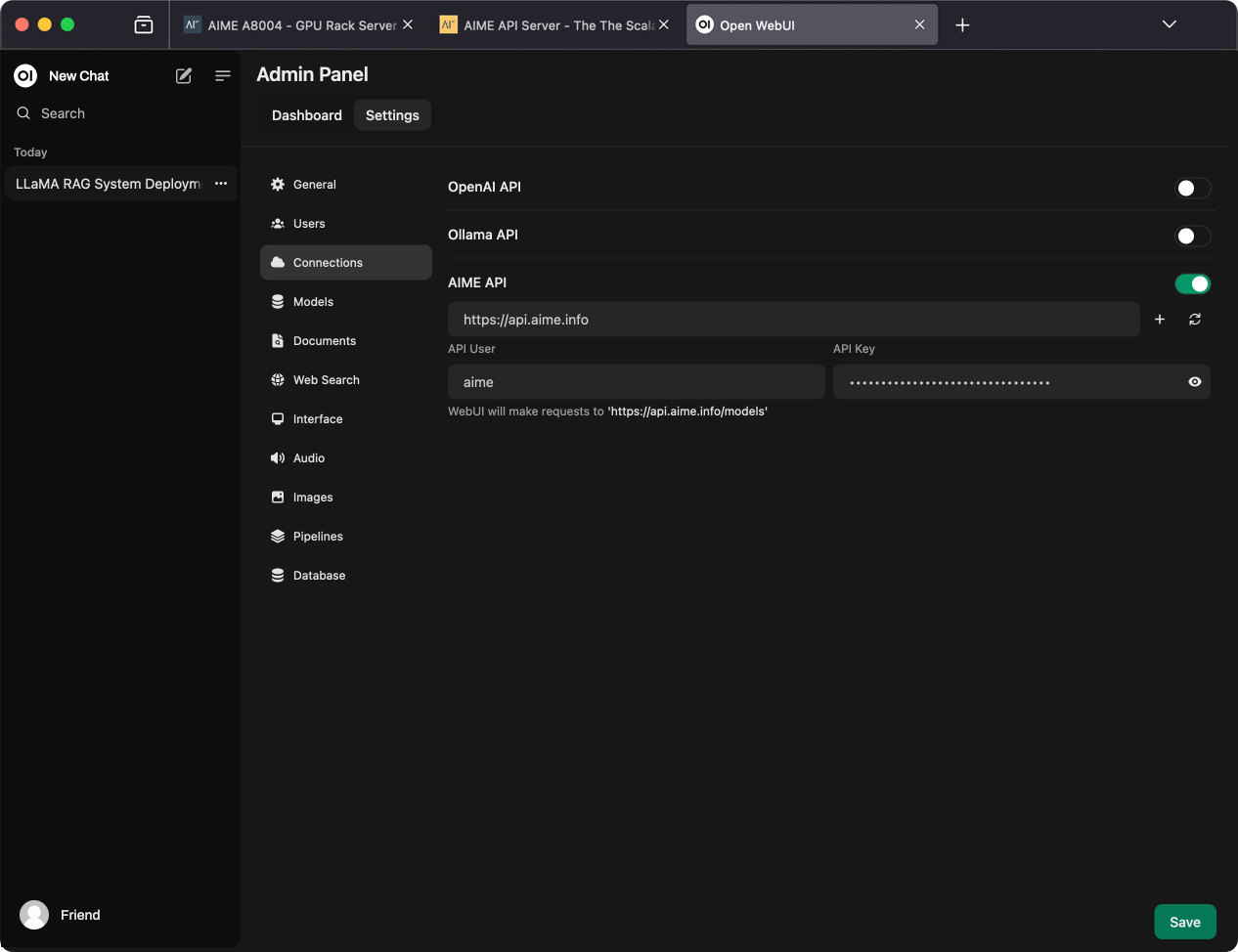

Um der steigenden Nachfrage nach datenschutzkonformen Integrationen von großen Sprachmodellen (LLMs), KI-Agenten und RAG-Lösungen gerecht zu werden, hat AIME das OpenWebUI-Framework um eine AIME API-kompatible Schnittstelle erweitert. Nutzen Sie OpenWebUI als modernes Chat-Frontend für LLMs, das vom AIME API-Server als skalierbares Backend unterstützt wird.

Damit können Sie Ihre eigene private Version eines ChatGPT-ähnlichen Sprachmodells betreiben – mit vollständiger Datensouveränität, ohne Kompromisse bei Leistung oder Funktionalität. Dies ermöglicht den sicheren Einsatz großer Sprachmodelle in Übereinstimmung mit höchsten Datenschutzstandards, bei gleichzeitig voller Kontrolle über Ihre Daten. Sie können dabei aus der Vielzahl von Sprachmodellen wählen, die vLLM unterstützt.

Betrieben werden kann OpenWebUI entweder als On-Premise-Lösung auf Ihrer eigenen Hardware (gerne auch bei uns gehostet) oder in Verbindung mit unseren DSGVO-konformen GPU-Cloud-Angeboten.

Kontaktieren Sie uns

Wenn sie Fragen haben rufen Sie uns an oder senden Sie uns eine E-Mail. Wir helfen Ihnen gerne bei der Suche nach der am besten geeigneten Rechenlösung.

-

AIME GmbH

Marienburger Str. 1

10405 Berlin

Deutschland