Artificial Intelligence Machines

HPC Server | Workstations | AI Cloud

Optimiert für Deep Learning & High Performance Computing

Kundenvertrauen in ganz Europa

In ganz Europa verwenden Forscher und Ingenieure an Universitäten, in Start-Ups, großen Unternehmen, Behörden und nationalen Labors etc. AIME-Produkte für ihre Arbeit zur Entwicklung künstlicher Intelligenz.

und viele weitere...

8x GPU Servers

4HE Server

AIME A8004

Der AIME A8004 ist der ultimative Multi-GPU-Server: Mit dualen EPYC Genoa oder Bergamo CPUs, schnellster PCIe 5.0 Busgeschwindigkeit, bis zu 90 TB RAID NVMe SSD Speicher und 100 GBE Netzwerkkonnektivität ist er optimiert auf maximale Deep-Learning-Trainings- und Inferenzleistung, und somit für die höchsten Anforderungen im HPC-Computing prädestiniert.

-

GPU:

1-8x NVIDIA H100 NVL 94 GB oder

1-8x NVIDIA H100 80 GB oder

1-8x NVIDIA A100 80 GB oder

1-8x NVIDIA L40S 48 GB oder

1-8x NVIDIA RTX 6000 Ada 48 GB oder

1-8x NVIDIA RTX 5000 Ada 32 GB oder

1-8x NVIDIA RTX A5000 24 GB - CPU: Dual AMD EPYC 16 - 96 Cores (Genoa), 112 - 128 Cores (Bergamo)

- RAM:256-3072 GB DDR5 ECC

- SSD: 2-30 TB, U.2 NVMe SSD

- RAID:2-6x 15 TB SSD NVMe RAID 0/1/5/10/50

4HE Server

AIME A8000

Mit dem AIME A8000 steigen Sie ein in den Peta FLOPS Bereich des Deep-Learning HPC-Computings: Mit bis zu acht GPUs oder Beschleunigern, dualer EPYC-CPU, 128 PCIe 4.0 Lanes-Busgeschwindigkeit und bis zu 100 GB Netzwerkkonnektivität erhalten Sie ein Multi-GPU-Arbeitspferd für den Einsatz in Ihrem Rechenzentrum oder Ihrer Co-Location.

-

GPU:

1-8x NVIDIA A100 80 GB oder

1-8x NVIDIA L40 48 GB oder

1-8x NVIDIA RTX 6000 Ada 48 GB oder

1-8x NVIDIA RTX A6000 48 GB oder

1-8x NVIDIA RTX 3090 24 GB oder

1-8x NVIDIA RTX A5000 24 GB - CPU: Dual AMD EPYC 8 - 64 Cores (Milan)

- RAM:128-2048 GB DDR4 ECC

- SSD: 2-30 TB, U.2 NVMe SSD

-

RAID:2-6x 20 TB HDD SATA RAID 0/1/5/10/50 oder

2-4x 15 TB SSD NVMe RAID 0/1/5/10/50

4x GPU Servers

2HE Server

AIME A4004

Der Deep-Learning-Server AIME A4004 angetrieben mit der neusten EPYC Genoa CPU Generation mit bis zu 4 GPUs oder Beschleunigerkarten. Verpackt in kompakten 2HE, höchste PCIe 5.0 Geschwindigkeit und bis zu 100 GBE Netzwerk-Konnektivität. Zuverlässigstes High Performance Multi-GPU-Computing für Ihr Rechenzentrum oder Co-Location.

2HE Server

AIME A4000

Der Vorgänger des AIME A4004 mit der EPYC Rome and Milan CPU Gerneration, hohe PCIe 4.0 Geschwindigkeit und bis zu 100 GBE Netzwerk-Konnektivität. Ihr effizienter High Performance Compute Knoten, der rund um die Uhr zuverlässig performt.

1-4x L40S 48 GB | RTX 6000 Ada 48 GB | RTX A6000 48 GB | RTX A5000 24 GB | Tesla V100S 32 GB

AIME Workstations

Workstation

AIME G400

Die perfekte Workstation für die Multi-GPU-Entwicklung von Deep Learning Modellen. Nutzen Sie die Leistung von bis zu vier GPUs und bleiben Sie flexibel bei der Entscheidung, ob Sie diese in Ihrem Büro oder in einem Rechenzentrum betreiben möchten. Die AIME G400 Workstation kann mit einem optionalen SlideRails-Kit in ein Standard-Rack eingebaut werden.

-

GPU:

2x NVIDIA RTX 4090 24 GB oder

1-4x NVIDIA RTX A5000 24 GB oder

1-4x NVIDIA RTX A6000 48 GB oder

1-4x NVIDIA RTX 6000 Ada 48 GB - CPU: AMD Threadripper Pro 16-64 Cores (Zen3)

- RAM: 64-512 GB DDR4 ECC

- SSD: 2x 1-8 TB, NVMe TLC

- HDD: 1-4x 16 TB 3.5'' SATA 7.200 RPM 512 MB Cache

AIME HPC Cloud

GPU Cloud Server

Multi-GPU-Server mieten

Mieten sie einen AIME Server in unserer AI-Cloud auf wöchentlicher oder monatlicher Basis, nur so lange, wie Sie ihn benötigen.

Sie erhalten vollen Remote-Zugang zu einem high-end multi-GPU Bare-Metal-Server, speziell zugeschnitten auf rechenintensive Projekte.

Sparen Sie sich Installationsaufwand und Administrationskosten, oder testen Sie einen AIME Server vor einem Kauf.

- Basic / Inference: Bis zu 8x NVIDIA RTX A5000 24 GB, 24 Cores, 256 GB Speicher

- Professional: Bis zu 8x NVIDIA RTX 6000 Ada 48GB, 10-40 vCores / 64 Cores, 60-512 GB Speicher

- Enterprise: Bis zu 8x NVIDIA A100 80GB | H100 94GB NVL, 14-56 vCores / 64 Cores, 120-1536 GB Speicher

Maßgeschneiderte Lösungen

Vermissen Sie Ihre Wunschkonfiguration? Wir bieten auch maßgeschneiderte Lösungen an. Bei uns finden Sie Hardware-Lösungen für maschinelles Lernen für:

- Entwicklungsteams

- Inhouse Unternehmensdienstleistungen

- Datenzentren

- Cloud Hosting

Features

Optimiert für Deep-Learning

Unsere Maschinen sind für Deep-Learning-Anwendungen konzipiert und optimiert.

Deep-Learning-Anwendungen erfordern schnellen Speicher, hohe Interkonnektivität und extrem viel Rechenleistung. Unser Multi-GPU-Design erreicht innerhalb dieses Formfaktors die derzeit höchstmögliche Performance.

Ausgewogene Komponenten

All unsere Komponenten werden auf Basis ihrer Energieeffizienz, Langlebigkeit und hohen Leistung ausgewählt. Sie sind perfekt aufeinander abgestimmt, um Leistungsengpässe zu vermeiden. Unsere Hardware ist auf ein optimales Preis-Leistungsverhältnis getrimmt, ohne dabei Kompromisse hinsichtlich Ausdauer und Zuverlässigkeit einzugehen.

Getestet mit anspruchsvollen Deep-Learning-Anwendungen

Unsere Hardware wurde in erster Linie für unsere eigenen Anwendungsanforderungen entwickelt. Sie ist aus jahrelanger Erfahrung mit Deep-Learning-Frameworks und kundenspezifischem Aufbau von PC-Hardware erwachsen.

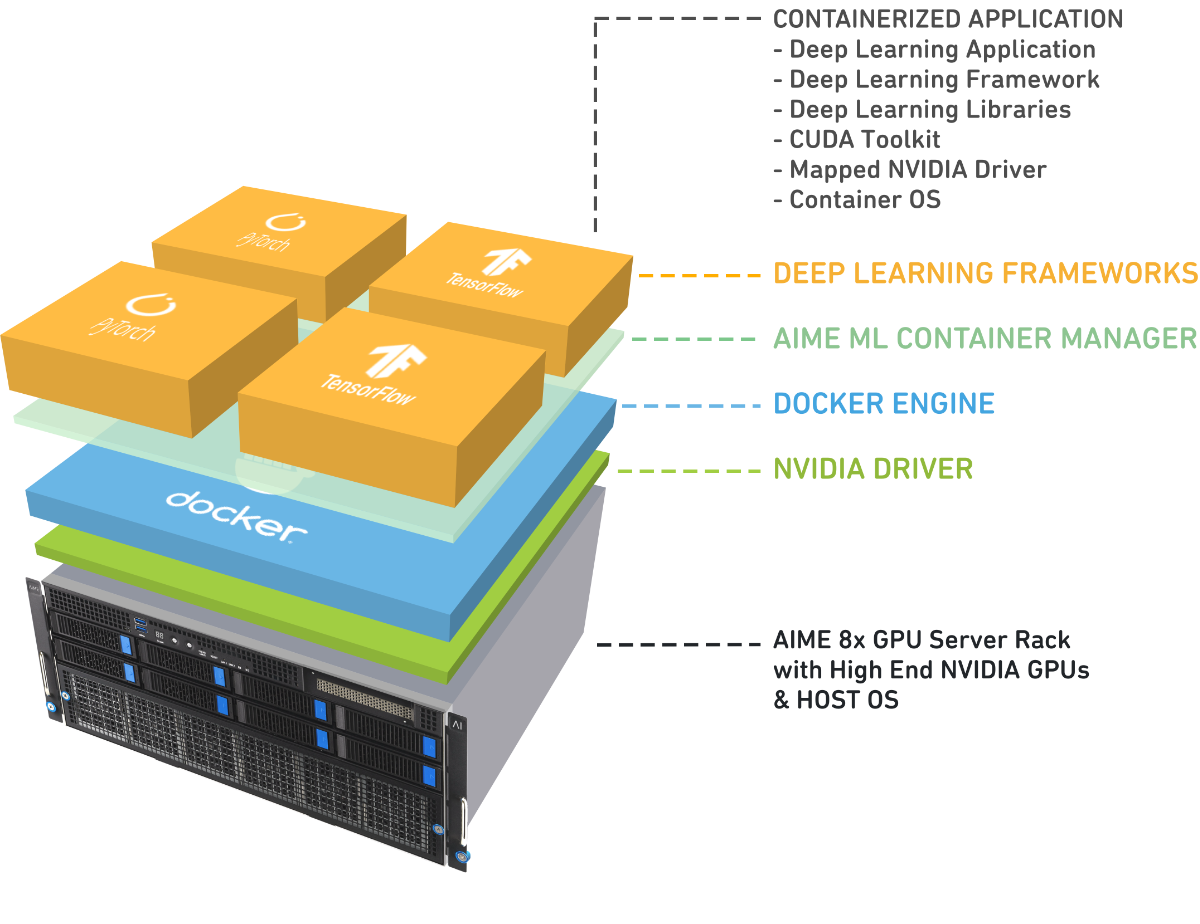

AIME ML Container Manager

für das Training von Modellen

Unsere Server und Workstations werden mit dem vorinstallierten AIME ML Container Manager ausgeliefert, einem umfassenden Software-Stack, mit dem Entwickler problemlos AI-Projekte einrichten und zwischen Frameworks und Projekten navigieren können.

Die für das jeweilige Deep Learning-Framework erforderlichen Bibliotheken und GPU-Treiber werden in vorkonfigurierten Docker-Kontainern geladen und können mit einfachen Befehlen konfiguriert und gestartet werden.

Die gängigsten Frameworks - u.a. TensorFlow, Keras, PyTorch und Mxnet - sind vorinstalliert und sofort einsatzbereit.

Der AIME ML Container Manager erleichtert Entwicklern das Leben, sodass sie sich nicht um Probleme bei der Installation der Framework-Versionen kümmern müssen.

Weiterlesen: AIME Machine Learning Framework Container Management

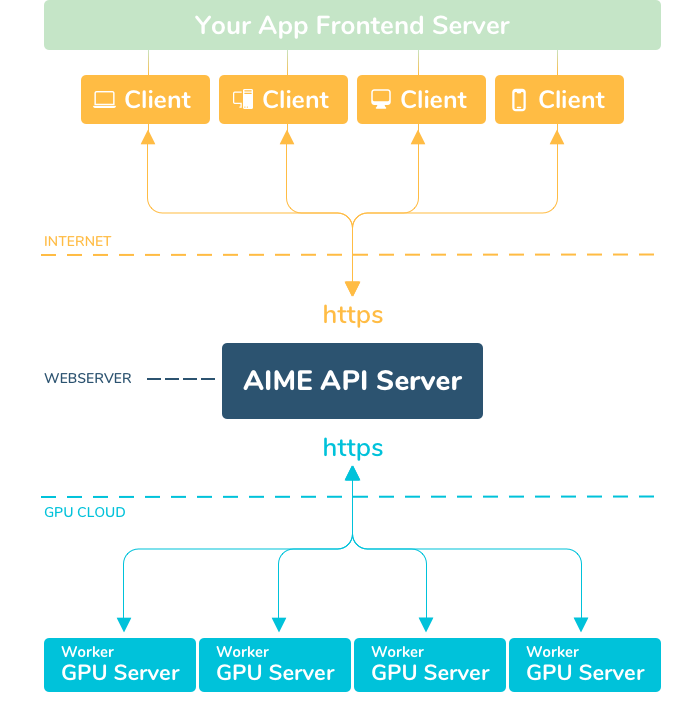

AIME API Server

für die Inferenz von Modellen

Sie haben ein Deep-Learning-Modell auf Ihrer Konsole oder Ihrem Jupyter-Notebook entwickelt und möchten es in Ihrem Unternehmen bereitstellen oder weltweit ausrollen? AIME API ist die einfache und skalierbare Lösung hierfür.

AIME-API stellt Deep-Learning-Modelle (PyTorch, TensorFlow) über eine Jobwarteschlange als skalierbaren API-Endpunkt bereit, mit der Millionen von Modell-Inferenzanfragen bedient werden können.

Verwandeln Sie ein Konsolen-Python-Skript in eine sichere und robuste Web-API, welche als Schnittstelle zur Mobil-, Browser- und Desktop-Welt fungiert.

Die AIME-API-Serverlösung umfasst eine verteilte Serverarchitektur, die einen zentralen API-Server verwendet, der über eine Job-Queue mit einem skalierbaren GPU-Computernetzwerk kommuniziert. Das GPU-Computernetzwerk kann heterogen sein und über verschiedene Standorte verteilt werden, ohne dass eine direkte Verbindung erforderlich ist. Die Client-Anfragen für die KI-Modelle werden von sogenannten Compute-Workern verarbeitet, die über eine sichere HTTPS-Schnittstelle mit dem API-Server verbunden sind. Der Standort der Compute-Workern kann unabhängig vom API-Server sein. Sie benötigen lediglich einen Internetzugang, um Aufträge anzufordern und die Rechenergebnisse zu senden.

Weiterlesen: AIME API - Die skalierbare KI-Modell-Inferenzlösung

Vorteile für Ihre Deep-Learning-Projekte

Schneller iterieren

Unproduktiv auf ein Ergebnis zu warten, ist frustrierend. Idealerweise sollte Ihre Maschine über Nacht trainieren, damit Sie die Ergebnisse gleich am nächsten Morgen überprüfen und weiterarbeiten können.

Modellkomplexität erweitern

Falls Sie Ihre Modelle aufgrund begrenzter Rechenzeit einschränken müssen, haben Sie mit Sicherheit nicht genügend Rechenzeit. Erreichen Sie größere Accuracy-Werte durch höhere Leistung und unbeschränkte Rechenzeit. Erweitern Sie die Größe Ihrer Modelle.

Trainieren Sie mit mehr Daten, lernen Sie schneller, führen Sie bei jeder Berechnung vollständige Iterationen durch.

Forschen ohne Kostenfalle

Aus Fehlern lernt man, sie gehören zum Entwicklungsprozess und sind nötig, um Modellstrukturen zu verfeinern. Ärgerlich ist es allerdings, wenn jeder Fehler in Euro abgerechnet wird, die Ihnen externe Cloud-Dienstleister in Rechnung stellen. Arbeiten Sie also nicht weiter gegen den Kostenzähler.

Schützen Sie Ihre Daten

Arbeiten Sie mit sensiblen Daten oder solche, die nur in Ihrem Unternehmen verarbeitet werden dürfen? Dann schützen Sie Ihre Daten, indem Sie diese nicht bei Cloud-Service-Providern hochladen, sondern auf Ihrer firmeneigenen Hardware verarbeiten.

Loslegen - Gleich nach dem Auspacken

Unsere Maschinen werden mit vorinstalliertem Linux-Betriebssystem geliefert, das mit den neuesten Treibern und Frameworks wie Tensorflow und PyTorch vorkonfiguriert sind. Starten Sie sofort nach dem Auspacken mit Ihrem bevorzugten Deep-Learning-Framework.

Weiterlesen: AIME Machine Learning Framework Container Management

Weiterlesen: AIME API - Die skalierbare KI-Modell-Inferenzlösung

Sparen Sie Geld

Cloud-Dienste, die eine vergleichbare Leistung bieten, haben einen Stundensatz von 14 Euro oder mehr. Diese Kosten können für die Anmietung einer einzelnen Instanz schnell auf Hunderttausende Euro pro Jahr ansteigen.

Unsere Hardware ist für einen Bruchteil dieser Kosten erhältlich und bietet die gleiche Leistung wie ein hochwertiger Cloud Service. Die Gesamtbetriebskosten / TCO sind gering, im Vergleich zu Cloud Service sparen sie dadurch monatlich Tausende von Euro an Servicekosten ein.

Wenn Sie keine eigene Hardware kaufen möchten, mieten Sie einen unserer Hosted-Bare-Metal-Server zu wettbewerbsfähigen Preisen.

Weiterlesen: CLOUD VS. ON-PREMISE - Total Cost of Ownership Analyse

Kontaktieren Sie uns

Wenn sie Fragen haben rufen Sie uns an oder senden Sie uns eine E-Mail. Wir helfen Ihnen gerne bei der Suche nach der am besten geeigneten Rechenlösung.

-

AIME GmbH

Marienburger Str. 1

10405 Berlin

Deutschland - +49 30 459 54 380

- hello@aime.info

- Mastodon

- Github